Como a NVIDIA pretende mudar as videochamadas com IA

SDK de streaming de vídeo NVIDIA Maxine com IA na nuvem é baseado na pesquisa com GANs apresentada no CVPR 2021 e pode revolucionar as videochamadas

Já pensou em levantar-se da cama, ligar o notebook, abrir a câmera e estar pronto para todas as videochamadas? Com a ajuda da Inteligência Artificial (IA) desenvolvida pelos pesquisadores da NVIDIA, isso já é possível. Ontem, participamos de uma apresentação “à portas fechadas” onde a NVIDIA mostrou novas tecnologias baseadas em IA com funções bem interessantes e principalmente economia no uso de banda necessário para uma qualidade de imagem excelente.

Durante a apresentação tive a oportunidade de fazer algumas perguntas, mais focadas para o público gamer e para streamers. No final desta matéria você vai poder conferir as perguntas e as repostas dadas

O Vid2Vid Cameo, um dos modelos de deep learning por trás do SDK NVIDIA Maxine para videochamadas, usa redes generativas adversariais, conhecidas como GANs, para sintetizar vídeos realistas com avatares usando apenas a imagem 2D de uma pessoa.

Para usá-lo, os participantes enviam uma imagem de referência – que pode ser uma foto real de si mesmos ou um avatar de desenho animado – antes de entrar em uma videochamada. Durante a reunião, o modelo de IA irá capturar o movimento em tempo real de cada indivíduo e aplicá-lo à imagem estática enviada anteriormente.

Isso significa que, ao enviar uma foto de si mesmos em trajes formais, os participantes da reunião, com cabelo despenteado e pijama, podem aparecer em uma chamada em trajes adequados para o trabalho, com IA mapeando os movimentos faciais do usuário para a foto de referência. Se a pessoa virar o rosto para a esquerda, a tecnologia pode ajustar o ponto de vista para que o participante pareça estar fazendo contato visual com a câmera.

Além de ajudar os participantes a melhorar sua aparência, essa técnica de IA também diminui em até 10 vezes a largura de banda necessária para videochamadas, evitando travamentos e atrasos. Em breve, ela estará disponível no SDK NVIDIA Video Codec sob o nome de AI Face Codec.

“A largura de banda da internet de muitas pessoas é limitada, mas elas ainda querem fazer videochamadas fluídas com a família e os amigos. Além de ajudá-los, essa tecnologia também pode ser usada para auxiliar o trabalho de animadores, editores de fotos e desenvolvedores de games”, afirma Ming-Yu Liu, Pesquisador da NVIDIA Enterprise e coautor do projeto.

O Vid2Vid Cameo foi apresentado nesta semana na famosa Conference on Computer Vision and Pattern Recognition como um dos 28 trabalhos da NVIDIA no evento virtual.

IA rouba a cena

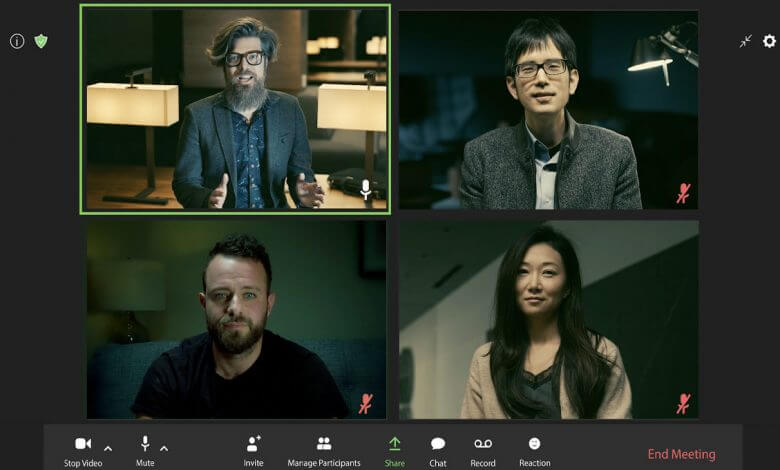

Em uma homenagem aos filmes clássicos de assalto (e a ‘La Casa de Papel’, série de sucesso da Netflix), os pesquisadores da NVIDIA Enterprise testaram o modelo representativo com GANs em uma reunião virtual. A demonstração destaca os principais recursos do Vid2Vid Cameo, como redirecionamento facial, avatares animados e compactação de dados. Você pode conferir um vídeo rápido (em inglês) com estes principais recursos logo abaixo:

Em breve, os recursos serão disponibilizados no SDK NVIDIA Maxine, que oferece aos desenvolvedores modelos pré-treinados otimizados para efeitos de vídeo, áudio e realidade aumentada em videochamadas e livestreams.

Os desenvolvedores já podem adotar os efeitos de IA do Maxine, como remoção inteligente de ruído, redimensionamento de vídeo e estimativa de pose corporal. O SDK gratuito também pode ser usado com a plataforma NVIDIA Jarvis para aplicações de IA de conversação, como transcrição e tradução.

Olá, da IA

O Vid2Vid Cameo precisa de apenas dois elementos para criar uma representação realista com IA para videochamadas: uma foto da pessoa e um stream de vídeo que define como a imagem deve ser animada.

Desenvolvido em um sistema NVIDIA DGX, o modelo foi treinado usando um conjunto de dados de 180 mil vídeos de alta qualidade de representações. A rede aprendeu a identificar 20 pontos principais que podem ser usados para modelar o movimento facial sem intervenção humana. Os pontos codificam a localização de características como olhos, boca e nariz.

Depois, o modelo extrai os pontos principais da imagem de referência da pessoa que está ligando, que pode ser enviada para outros participantes da videochamada com antecedência ou reutilizada de reuniões anteriores. Assim, em vez de enviar streams pesados de vídeo de um participante para o outro em tempo real, as plataformas de videochamadas podem enviar apenas dados do movimento dos principais pontos faciais da pessoa que está ligando.

No lado da pessoa que está recebendo a chamada, o modelo com GANs usa as informações para sintetizar um vídeo que imita a aparência da imagem de referência.

Ao compactar e enviar pela rede apenas a posição e os pontos principais da cabeça em vez de streams completos de vídeo, a técnica reduz em 10 vezes a largura de banda necessária para videoconferências, proporcionando ao usuário uma experiência mais fluida. É possível ajustar o modelo para que ele transmita um número maior ou menor de pontos principais e se adapte a diferentes níveis de largura de banda sem afetar a qualidade visual.

O ponto de vista do vídeo gerado com a representação também pode ser ajustado à vontade para mostrar o perfil ou o ângulo frontal do usuário, além de um ponto mais baixo ou mais alto da câmera. Este recurso também pode ser aplicado por editores de fotos que trabalham com imagens estáticas. Confira o vídeo (em inglês) sobre a compressão de imagem por IA:

Os pesquisadores da NVIDIA Enterprise descobriram que o Vid2Vid Cameo supera os modelos de última geração, produzindo resultados mais realistas e mais nítidos. Isso vale tanto para a imagem de referência e o vídeo da mesma pessoa quanto para a transferência do movimento de uma pessoa para a imagem de referência de outra com o auxílio da IA.

É possível usar esse último recurso para aplicar os movimentos faciais da pessoa que está falando e animar um avatar digital, conferindo expressões e movimentos realistas a uma figura de desenho animado.

O artigo sobre o Vid2Vid Cameo foi escrito pelos pesquisadores Ting-Chun Wang, Arun Mallya e Ming-Yu Liu da NVIDIA Enterprise. A equipe da NVIDIA Research é formada por mais de 200 cientistas de todo o mundo especializados em áreas como IA, visão computacional, automóveis autônomos, robótica e gráficos.

MINHA VISÃO SOBRE AS NOVIDADES E PERGUNTAS AOS CIENTISTAS E GERENTES DE PROJETOS

Basicamente 3 foram as técnicas destacadas nesta apresentação, e vou passar para vocês, de acordo com a minha experiência em trabalho remoto em uma multinacional há mais de um, como estas tecnologias podem impactar o dia a dia de videochamadas:

- Redirecionamento facial: extremamente útil quando você usa mais de um monitor e está fazendo uma apresentação com roteiro pré-definido, podendo ler tranquilamente e ao mesmo tempo parecer para a audiência que você está olhando para a câmera. O mesmo serve para setups onde a câmera não está posicionada de frente para o usuário, ajudando com que ele pareça estar olhando diretamente para a lente.

- Avatares animados: extremamente divertido e quebra gelo, principalmente para reuniões sem maiores impactos ou de sensibilidade grande. Este tipo de implementação pode deixar o dia a dia de várias reuniões muito mais leve. Me lembrou bastante os emoji AR da Apple e Samsung.

- Compactação de dados: aqui é onde há maior impacto, de longe. O comparativo que eles fizeram com o codec H264 usando 0.0016 bits por pixel contra a compressão de vídeo baseada em inteligência artificial, usando os mesmos 0.0016 bits por pixel, foi incrível. A diferença é abissal e certamente vai impactar positivamente dois cenários: pessoas com bandas limitadas, podendo ter qualidade de imagem bem superior, e grande qualidade de imagem para pessoas com banda suficiente, fazendo parecer que seu setup é muito mais profissional.

Depois de ver as tecnologias em ação, consegui fazer 3 perguntas para o time, todas elas respondidas pela Alex Qi – Project Manager, AI Aplications and Deep Learning Software. Abaixo vou resumir as perguntas e respostas:

Pedro Nogueira: Todas estas tecnologias, principalmente a de redução de consumo de banda, estarão disponíveis em programas para stream de jogos (tipo OBS)?

Alex Qi: Agora nós ainda estamos procurando cenários de usos reais e streaming de jogos é definitivamente um dos cenários em que estaremos olhando também. Ainda estamos no processo e vamos avisa-los quando tivermos progresso.

Pedro Nogueira: Podemos esperar por um novo codec NVENC para a família RTX com estas tecnologias de IA embarcadas?

Alex Qi: Eu diria fiquem ligados pois estamos considerando a inclusão desta tecnologia, de novos add-ons, através do SDK do codec da NVIDIA. Isto está em nosso roadmap de lançamento e certamente se você tem uma GPU da família RTX poderá tirar proveito das vantagens destas novas adições.

Pedro Nogueira: A tecnologia de avatar pode ser incluída no NVIDIA Broadcast?

Alex Qi: Ainda não finalizamos as decisões para o NVIDIA Broadcast. No momento vamos mantê-los atualizados para quando tivermos mais detalhes.

Já pensou que incrível tirar proveito desta novo codec para lives usando OBS? Ou algum software proprietário futuro da própria NVIDIA? Imagina a tecnologia de avatar incluída no NVIDIA Broadcast, onde já é possível com IA trocar o fundo, remover fundo e muito mais? São tecnologias bem empolgantes não somente pro mundo corporativo, mas também para o cenário de games. Agora é torcer para que a NVIDIA expanda os horizontes e entregue estas tecnologias para gamers também!