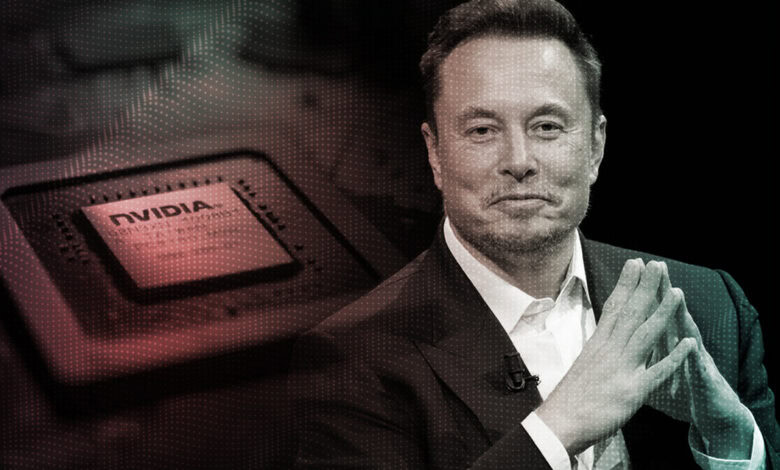

Elon Musk compartilhou novos detalhes sobre os planos da xAI para construir um cluster de 100 mil GPUs NVIDIA Hopper, com o objetivo de treinar o modelo de inteligência artificial Grok 2. Após encerrar a parceria com a Oracle, que havia fornecido 24 mil GPUs para o projeto, a xAI decidiu construir internamente o que Musk descreve como “o cluster de treinamento mais poderoso do mundo”.

NVIDIA revela GPUs da nova linha GeForce RTX 50 Blackwell

A decisão de seguir um caminho independente visa acelerar o progresso no desenvolvimento da IA, permitindo à xAI competir de forma mais eficiente com outras empresas do setor. A Oracle, por sua vez, está colaborando com a Microsoft para fornecer 100 mil chips NVIDIA Blackwell GB200, os processadores de IA mais recentes do mercado.

Musk enfatizou a importância de completar o sistema de 100 mil GPUs no menor tempo possível para manter a competitividade da xAI. A expectativa é que o sistema comece a treinar ainda este mês e seja finalizado até agosto. O executivo acredita que essa abordagem permitirá à xAI alcançar a “maior velocidade de conclusão” e superar outras empresas de IA.

A construção do sistema com GPUs H100, em vez de continuar a parceria com a Oracle, é vista como uma estratégia para garantir a rapidez necessária. Musk já havia mencionado anteriormente planos para um sistema com 300 mil GPUs Blackwell, que poderia custar até 9 bilhões de dólares. No entanto, a opção pelo sistema H100 visa otimizar o tempo de desenvolvimento.

O modelo Grok 2 da xAI, que está em fase final de ajustes e correções de bugs, deve estar disponível no próximo mês. Enquanto outras empresas como Meta, Alphabet e Amazon investem pesadamente em chips de IA, a xAI busca se destacar com um sistema de treinamento altamente eficiente e poderoso.

Esses avanços no setor de IA colocam a NVIDIA em uma posição de destaque, com suas GPUs se tornando essenciais para o desenvolvimento de novos modelos de inteligência artificial.